Ranking en Research management

Hoe kun je het wetenschappelijk onderzoek meten en de prestaties van universiteiten met elkaar vergelijken?

[In de ranking-systemen worden alleen universiteiten met elkaar vergeleken, omdat er voor onderzoeksinstituten - zoals bijv. het excellent presterende Max Planck Inst. geen vergelijkbare plek is, ook niet voor afzonderlijke onderzoeksinstituten. ook noemt Van Raan het probleem van de academische ziekenhuizen, die vaak verantwoordelijk zijn voor de helft van de output, maar soms moeilijkaan een universiteit te koppelen].

Allen zijn gebaseerd op de 2 commerciële producten (WoS)en (Scopus).

1. TimesHigher Education is ingedeeld in 5 categorien (teaching, research, citations, industry income, international) met een verschillende weging gebaseerd op ‘expert enthusiasm’. 2/3 is gebaseerd op citaties.

2. QS deelt ongeveer in dezelfde categorieen in, maar heeft als extra ‘employer reputation’

3. Shanghai, Academic Ranking of World Universities(ARWU), is heel erg ‘size dependent’. Trotsop oude prijswinnaars, maar zegt niets over potentieel. Bij citaties wordt alleen gekeken naar de highly cited (dus past performance)met nadruk op reputatie.

4. Leidenranking .Het kost veel tijd om websites na te kijken en om netwerk met contactpersonente onderhouden. Ranking op basis van genormaliseerde bibliometrische indicatoren, nu MNCS2 (voorheen CPP/FCSm). Het algemeen plaatje is dat als je als universiteit bij eerste 300 hoort het nog goed zit, daarna gaat de curve scherp naar beneden (hypothese van Raan: er zijn niet meer goede wetenschappers om meer goede universiteiten te bevolken). Voor Frans en Duits zijn aparte lijsten gemaakt.Gemiddelden in studies zijn niet altijd de beste indicator vanwege de ‘skewed distribution’, dan is highly cited beter (A/EPtop10%)

5. U-Multirank, een EU-project.

Naast dit soort ranking kunje ook op andere terreinen aan internationale benchmarking doen. Maar het is lastig om vergelijkbare indicatoren op te stellen.Tijssen geeft een overzicht van de wetenschappelijke indicatoren; technologie-indicatoren (zie ook het University-industry Scoreboard van CWTS); en innovatie indicatoren (bijv. voor het EriC,Evaluation of Research in Context van de KNAW en VSNU is geprobeerd te valoriseren, maar verder dan showcases komt men (nog) niet.

Ook Leru heeft alleen case-beschrijvingen).

Science mapping

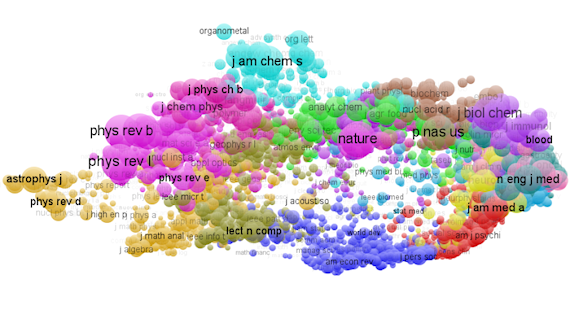

Naast het ranken wordt er m.b.v. allerlei moderne textmining instrumenten geprobeerd de hele wetenschap in kaart te brengen. Kaarten die gebaseerd zijn op de bibliometrische netwerken van publicaties, co-auteurschap, cocitaties e.d.CWTS heeft voor visualisering van die gegevens de zogenoemde VosViewer ontwikkeld. Door de kaarten kun je aldus Noyons en Waltman, dichter bij de data blijven. De kaarten maken clustering mogelijk en kunnen verschillende dimensies weergeven. Van de basis bibliometrische netwerken, maak je afgeleide netwerken die je naar symmetrische matrixen kunt overbrengen en die kun je visualiseren.Zo heeft CWTS bijvoorbeeld alle onderwerpsgebieden uit WoS voor indelen van tijdschriften in kaart gebracht.Dat geeft toch een mooi beeld van de wetenschap en de vertegenwoordiging van artikelen in de WoS-database. [Ik kan me herinneren dat we vroeger zoiets geprobeerd hebben m.b.v. thesauri, maar dat is toen gestrand, ook vw de omvang]. Ook een mooie is de kaart van de tijdschriften zelf:

Hoe kun je het wetenschappelijk onderzoek meten en de prestaties van universiteiten met elkaar vergelijken?

[In de ranking-systemen worden alleen universiteiten met elkaar vergeleken, omdat er voor onderzoeksinstituten - zoals bijv. het excellent presterende Max Planck Inst. geen vergelijkbare plek is, ook niet voor afzonderlijke onderzoeksinstituten. ook noemt Van Raan het probleem van de academische ziekenhuizen, die vaak verantwoordelijk zijn voor de helft van de output, maar soms moeilijkaan een universiteit te koppelen].

Allen zijn gebaseerd op de 2 commerciële producten (WoS)en (Scopus).

1. TimesHigher Education is ingedeeld in 5 categorien (teaching, research, citations, industry income, international) met een verschillende weging gebaseerd op ‘expert enthusiasm’. 2/3 is gebaseerd op citaties.

2. QS deelt ongeveer in dezelfde categorieen in, maar heeft als extra ‘employer reputation’

3. Shanghai, Academic Ranking of World Universities(ARWU), is heel erg ‘size dependent’. Trotsop oude prijswinnaars, maar zegt niets over potentieel. Bij citaties wordt alleen gekeken naar de highly cited (dus past performance)met nadruk op reputatie.

4. Leidenranking .Het kost veel tijd om websites na te kijken en om netwerk met contactpersonente onderhouden. Ranking op basis van genormaliseerde bibliometrische indicatoren, nu MNCS2 (voorheen CPP/FCSm). Het algemeen plaatje is dat als je als universiteit bij eerste 300 hoort het nog goed zit, daarna gaat de curve scherp naar beneden (hypothese van Raan: er zijn niet meer goede wetenschappers om meer goede universiteiten te bevolken). Voor Frans en Duits zijn aparte lijsten gemaakt.Gemiddelden in studies zijn niet altijd de beste indicator vanwege de ‘skewed distribution’, dan is highly cited beter (A/EPtop10%)

5. U-Multirank, een EU-project.

Naast dit soort ranking kunje ook op andere terreinen aan internationale benchmarking doen. Maar het is lastig om vergelijkbare indicatoren op te stellen.Tijssen geeft een overzicht van de wetenschappelijke indicatoren; technologie-indicatoren (zie ook het University-industry Scoreboard van CWTS); en innovatie indicatoren (bijv. voor het EriC,Evaluation of Research in Context van de KNAW en VSNU is geprobeerd te valoriseren, maar verder dan showcases komt men (nog) niet.

Ook Leru heeft alleen case-beschrijvingen).

Science mapping

Naast het ranken wordt er m.b.v. allerlei moderne textmining instrumenten geprobeerd de hele wetenschap in kaart te brengen. Kaarten die gebaseerd zijn op de bibliometrische netwerken van publicaties, co-auteurschap, cocitaties e.d.CWTS heeft voor visualisering van die gegevens de zogenoemde VosViewer ontwikkeld. Door de kaarten kun je aldus Noyons en Waltman, dichter bij de data blijven. De kaarten maken clustering mogelijk en kunnen verschillende dimensies weergeven. Van de basis bibliometrische netwerken, maak je afgeleide netwerken die je naar symmetrische matrixen kunt overbrengen en die kun je visualiseren.Zo heeft CWTS bijvoorbeeld alle onderwerpsgebieden uit WoS voor indelen van tijdschriften in kaart gebracht.Dat geeft toch een mooi beeld van de wetenschap en de vertegenwoordiging van artikelen in de WoS-database. [Ik kan me herinneren dat we vroeger zoiets geprobeerd hebben m.b.v. thesauri, maar dat is toen gestrand, ook vw de omvang]. Ook een mooie is de kaart van de tijdschriften zelf:

Wetenschapsbeleid

Cornelis van Bochove neemt een heel andere invalshoek, hij kijkt naar de invloed van Human Resources Management en carrière-politiek op de wetenschappelijke prestaties.Stelling ”Scienceoutput is the sum of competence, aptitude and randomness”. Hij wil onderzoeken of het voor de prestaties wat uitmaakt als je een onderzoeker eerder een vaste aanstelling geeft, dus eerder in zijn carrière uitselecteert. Hij laat met een Pareto-distributie zie hoe dat in de verschillende scenario’s eruit ziet. Als verschillen tussen mensen groter zijn, dan is de invloed van selectie op totale output enorm. Snelle selectie levert dus meer op.Van Bochove kijkt ook naar de economische groei, wat is het aandeel van de wetenschap in de economische groei. Daarbij komt hij tot nogal wat verrassende uitspraken. Fundamenteel onderzoek is nodig om de barriere van de ‘known laws of nature’ te verleggen. Fundamenteel onderzoek vraagt om extra getalenteerde mensen, waarbij de tijdsfactor (=leerfactor) belangrijker is dan geld; meer Einsteins, of rijkere Einsteins hadden niet sneller de relativiteitstheorie kunnen ontdekken. Je krijgt snelle groei als je veel geld stopt in toegepaste R&D op basis van bekende ‘laws of nature’ (zie Azie)Je krijgt stabiele groei op basis van het basic research model afhankelijk van leertijd (zie Japan, vanaf 80 jaren hadden ze niveau van het Westen gehaald en basic research genegeerd toen ging het neerwaarts).De essentie van economische groei zit hem dus, aldus Van Bochove in het Basic Research Model.Die boodschap, om met name te investeren in fundamenteel onderzoek is een interesante gedachte en zal hij uitwerken in een nog te verschijnen artikel.

Cornelis van Bochove neemt een heel andere invalshoek, hij kijkt naar de invloed van Human Resources Management en carrière-politiek op de wetenschappelijke prestaties.Stelling ”Scienceoutput is the sum of competence, aptitude and randomness”. Hij wil onderzoeken of het voor de prestaties wat uitmaakt als je een onderzoeker eerder een vaste aanstelling geeft, dus eerder in zijn carrière uitselecteert. Hij laat met een Pareto-distributie zie hoe dat in de verschillende scenario’s eruit ziet. Als verschillen tussen mensen groter zijn, dan is de invloed van selectie op totale output enorm. Snelle selectie levert dus meer op.Van Bochove kijkt ook naar de economische groei, wat is het aandeel van de wetenschap in de economische groei. Daarbij komt hij tot nogal wat verrassende uitspraken. Fundamenteel onderzoek is nodig om de barriere van de ‘known laws of nature’ te verleggen. Fundamenteel onderzoek vraagt om extra getalenteerde mensen, waarbij de tijdsfactor (=leerfactor) belangrijker is dan geld; meer Einsteins, of rijkere Einsteins hadden niet sneller de relativiteitstheorie kunnen ontdekken. Je krijgt snelle groei als je veel geld stopt in toegepaste R&D op basis van bekende ‘laws of nature’ (zie Azie)Je krijgt stabiele groei op basis van het basic research model afhankelijk van leertijd (zie Japan, vanaf 80 jaren hadden ze niveau van het Westen gehaald en basic research genegeerd toen ging het neerwaarts).De essentie van economische groei zit hem dus, aldus Van Bochove in het Basic Research Model.Die boodschap, om met name te investeren in fundamenteel onderzoek is een interesante gedachte en zal hij uitwerken in een nog te verschijnen artikel.

Geen opmerkingen:

Een reactie posten