Het jaarcongres KNVI als opvolger van de NVB-congressen. Sinds het predikaat 'koninklijk'vorig jaar is uitgereikt heet de vereniging niet meer NVB (van Nederlandse Vereniging Bibliothecarissen - kater toegevoegd met andere beroepsbeofenaars) maar KNVI (Koninklijke Nederlandse Vereniging van Informatieprofessionals). - In onze beroepsgroep is het gebruikelijk om van naam te veranderen als men denkt dat er iets met het imago moet. -

De titel van het congres is: "Hoera, een informatieprofessional".

HOERA!

Het logo van de ronddolende poppetjes die uiteindelijk de weg gewezen wordt door de ene informatieprofessional in rood, is bedoeld als illustratie bij deze lead. Mooi bedacht door J. Minnema.

Tussen de honderden sollicitatiebrieven springt er één meteen uit: die van de informatieprofessional die een einde maakt aan de informatie chaos die in het bedrijf is ontstaan en ervoor gaat zorgen dat in de toekomst gegevens eenvoudig, snel en transparant toegankelijk zijn: Hoera, een InformatieProfessional.

Er werden zo'n duizend mensen verwacht en die zouden zich moeten opdelen in 8 tracks. Het Nieuwegeins Business Centre (NBC) heeft op de begane grond een vierkante beursvloer voor standhouders, koffie, lunch en borrel, met een grote zaal aan de zijkant en kleiner zaaltjes op de 1e verdieping.

Ik heb in de ochtend voor de track 'Radicale Keuzes' gekozen, waarschijnlijk omdat ikzelf ook wel van radicale keuzes hou.

Er bleek geen plenaire aankondiging vooraf te zijn, maar na de koffie konden we meteen met de track beginnen: Simone Kortekaas van de UB Utrecht over het sluiten van hun zoekmachine Omega. Trends naar het zoekgedrag toonden aan dat mensen eerder via Google Scholar zochten en slechts weinigen via hun eigen discovery-tool. De vraag was dus gerechtvaardigt of het nog wel loont om energie te steken in de ontwikkeling van een optimale zoekmachine. Nee, was de conclusie. Laten we ons richten op Delivery.

VAN DISCOVERY NAAR DELIVERY

En dus richtten ze de website geheel nieuw in, zonder zoekvakje, maar wel met extra links en uitleg. Een goed communciatieplan, exttra uitleg (fantastische Libguides) en een 'Betervinden"-pagina en via sociale media (Facebook en met twitter-hashtags #betervinden en #biebtip).

Voor remote access heeft de UU een bookmarklet ontwikkeld waarmee de mensen extra makkelijk toegang tot publicaties en zoeksystemen kunnen krijgen. De catalogus is nog wel in beeld, maar zal langzaam worden uitgefaseerd.

Wat ik me wel afvraag bij deze ontwikkeling is het onderhoud van de eigen systemen. Als je de felivery, goed wilt doen, dan zul je toch zelf ook iets van een catalogus ofg anderszins collectie-aanwijzer moeten inzettebn. Anders lukt delivery ook niet.

Zelf hebben wij juist vanuit onze delivery tool (de linksolver = daar staat onze collectie in beschreven) reen discovery-dienst opgezet.

Maar wellicht is de idee wel valide dat je het zoeken beter kjunt overlaten aan systemen, zoals Google Scholar, die er goed in zijn.

Radicaal is de keuze van de UB utrecht in ieder geval wel. Er meldde zich niemand die het ze nadoet.

De radicale keuze van de volgende spreker, Richard Wallis van OCLC, had eigenlijk ook te maken met locale bibliotheeksystemen. Die tijd is voorbij, met linked data kun je alles aan elkaar knopen en kun je in plaats van een catalogus een catalink aanbieden.

FROM CATALOGUING TO CATALINKING

Wallis raadt aan om samen te werken aan omvorming van bibliotheeksystemen richting linked data en toont de stappen die OCLC met Worldcat al gezet heeft om linked data op te nemen. Ze volgen schema.org als markup vocabulary. Richard roept op "Be visible on the web of data linking to all their resources".

Na een goede lunch op de beursvloer, enkele interessante standbezoekjes (Browzine) en wat leuke gesprekjes heb ik me aangesloten bij de Trach "De vrije informatieprofessional". In deze track werd een video getoond van Brewster Kahle van Internet Archive, die zelf niet kon komen wegens een recentelijke brand.

De ambitie van Kahle is om alles wat gemaakt is toegankelijk maken free to all en daarvoor zet hij zichzelf en zijn met webbedrijf verdiende miljoenen voor in. Een loffelijk streven. En op Internet Atrchive is dan ook van alles te vinden, alles probeer hij te digitaliseren: boeken, films, muziek, foto's. Hij heeft de WayBackMachine ontworpen en de Open Library. De passie waarmee hij zich inzet is bewonderenswaardig.

FREE UP OLD MATERIAL, OR AT LEAST FREE THE NEW PUBLICATIONS

In principe biedt het Internet Archive alle materialen open access aan. Als de rechthebben klaagt kan het, uiteindelijk altijd nog van het web gehaald worden. Maar Kahle is ook niet te beroerd om te vechten voor wat hij wil en voert daar zelfs processen voor.

Auteursrecht is wel een issue, zegt ook het panel.

In het panel een aantal Wikipedianen, die zelf proberen om in ieder geval de copyright-status van de door hen aangeboden materialen, bijv. in Wikimedia Commons, duidelijk te maken.

De discussie was wat tam, maar werd over auteursrecht toch even serieus.

De copyright-discussie bij vrije IP'er track werd plenair voortgezet door Marietje Schaake, politica over auteurswet voor digitale producten. Het auteursrecht is verouderd vindt zij en zou veel meer open moeten, onder verwijzing naar het EU-programma Horizon 2020 en de Digitale Agenda van Neelie Kroes (netneutraliteit).

De plenaire uitgeleiding van de dag bestond vervolgens nog uit een treurigstemmende pitch van Hans van Hartevelt over de ondergang van de KIT-bibliotheek, de stoet van externe consultants, de redding door de bibliotheek van Alexandrië, een Pyrrhusoverwinning noemde hij het. Hij heeft wel een overlevingsstrategie geleerd: wat niet werkt is een goede evaluatie, voldoende kostendekkend, en markt- en klantgerichtheid. Het enige dat telt is onafhankelijkheid van de overheid.

Prof. Jeroen van den Hoven van TUDelft sprak over 'Big data en IP'ers' : informatieprofessionals kunnen een refugiun libertatis bieden aan de dolende burger op zoek naar burgervrijheden.

En met een slotwoord van de voorzitter en een gezellig borrel toe, besloten we de dag.

Weblog over mijn werk als informatiespecialist bij het Nederlands Instituut voor Ecologie (NIOO-KNAW).

19 nov 2013

KNVI-congres

14 okt 2013

Bezoek aan Nationaal Herbarium

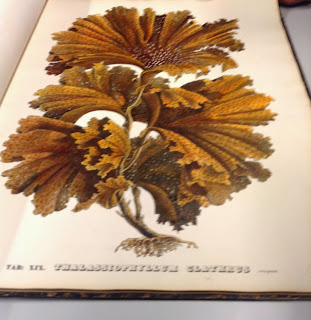

Op vrijdag 11 oktober 2013 bracht ik samen met enkele andere leden van de Amsterdamse KNNV een bezoek aan het Nationaal Herbarium in Leiden. Dit bezoek was onderdeel van een introductie over zeewieren van dr. Herre Stegenga en dr. Willem Prud'homme van Reine.

Bij de lezing: Zeewieren komen met name voor op vast substraat, dus zijn ze voor Nederland vooral gebonden aan kunstmatige structuren. Door de Deltawerken zijn de omstandigheden gewijzigd en vooral in de Oosterschelde verbeterd. Dit laatste heeft te maken met het zo veel mogelijk weren van zoetwaterinflux. Het gevolg is het gestadig toenemen van het aantal soorten, sinds het verschijnen van een flora in 1983 bedraagt dit al zo’n vijftig soorten. Een belangrijk deel daarvan bestaat uit exoten, soorten die hier zonder bemoeienis van de mens niet zouden kunnen komen. Ze kunnen binnen enkele jaren zeer abundant (overvloedig) worden. De origine van veel soorten is het Verre Oosten (Japan, China, Korea) – deze specifieke voorkeur heeft waarschijnlijk te maken met vergelijkbare temperatuuromstandigheden (relatief hoge maxima en lage minima). Gevolg is dat vooral rond de laagwaterlijn de flora een exotisch uiterlijk krijgt. Dr. Herre Stegenga en Dr. Willem Prud’homme van Reine ontvangen ons en zullen een demonstratieve show geven met herbariumexemplaren van zeewieren uit de nationale collecties. Mogelijk kunnen ze ons ook belangrijke platenwerken op zeewierengebied uit de bibliotheek tonen

Het Nationaal Herbarium Nederland (NHN) is nu nog gevestigd in het Van Steenisgebouw, Einsteinweg 2 in Leiden, het gebouw van de afdeling Biologie van de Unversiteit Leiden. Het Nationaal Herbarium is ontstaan uit een fusie van de herbaria van Leiden, Utrecht en Wageningen in 1999. Vanaf 2009 zijn ze losgemaakt van de universiteit Leiden en ondergebracht bij Naturalis Biodiversity Center. Naturalis Biodiversity Center herbergt niet alleen het nationaal natuurmuseum, maar ook alle nationale biologische collecties.

Vanaf volgend jaar (2014) gaat er een grote gebouw- en verbouw- actie beginnen die uiteindelijk moet uitmonden in de oprichting van een 2e collectietoren van Naturalis en een verhuizing van alle medewerkers naar de NBC-gebouwen.

Willem Prud'homme van Reine, die de rondleiding leidde vertelde ons dat wij de laatste groep zijn die een rondleiding krijgt door het 'oude' herbarium.

Er zijn 4 grote collectiezalen.Sommige met verrolbare kasten en andere met vaste kasten, maar allemaal met eindeloze rijen met dozen. In de dozen zitten mappen met daarin de gedroogde specimen, tussen 'flap' bladen. Die planten die gevoelig zijn voor vraat van beestjes gaan 1x per jaar in de diepvries van -25 graden. Er zijn in het herbarium zo'n kleine 6 miljoen specimen aanwezig (incl. de Utrechtse houtspecimen en de Wageningse cultuurgewassen).

Men is nu bezig met een uitgebreide digitaliseringsslag. Daartoe gaan stapels dozen naar een digitaliseringsbedrijf. Er worden dan 20.000 specimen per dag gedigitaliseerd. Bij terugkomst gaan de dozen eerst in de vrieskist voor ze weer op hun plek teruggezet worden. De firma Picturae heeft 7 digistraten ingericht voor Naturalis en het doel is om zo'n 7 milj. objecten te digitaliseren, waarvan 4,5 milj herbarium bladen en 130k houtspecimen uit het herbarium. De Volkskrant wijdde er nog een artikel aan (lees op site Picturae) en ook in Wageningen wordt gedigitaliseerd, aldus een berichtje in Resource van 26 september 2013. De collectie omvat naast alle Nederlandse soorten ook een uitgebreide collectie planten uit Indonesie en Nieuw-Guinea, tropisch Africa en Antillen.

Het resultaat van de digitalisering is te zien in de database .

In het voorbeeld gezocht op Taraxacum officinale (paardenbloem).Niet alleen zijn er planten gedroogd bewaar ook zijn er een groot aantal bewaard in alcohol en/of formaline. Dat levert een hele zaal met potjes en - ontkleurde - bloemen op.

Dr. Herre Stegenga (schrijver van "Flora van de Nederlandse zeewieren", uitgave van KNNV uit 1983) toonde ons een aantal exotische soorten zeewieren, die nieuw zijn voor Nederland.

Een van de nieuwe soorten is de Wakame (Undaria pinnatifia), waarvan we ook een stukje snack met zeewiersalade uit de schappen van Albert Heijn konden proeven. De meeste zeewieren kun je eten, behalve een soort als de Desmarestia viridis, die zoveel zuur heeft dat hij alles in zijn buurt verbrokkelt.

Heel mooi, en makkelijk te onthouden is de Turuturu (Grateloupia turuturu Yamada) een prachtige grote roodwier.

Ter afsluiting brachten we een bezoekje aan de NHN-bibliotheek, qua catalogus al wel geintegreerd met de Naturalis-bibliotheek, maar nog wel apart gehuisvest en met een eigen kamer met speciale, oude, handgetekende en ingekleurde boeken. We keken naar enkele zeldzame exemplaren van boeken over algen.

7 okt 2013

TPDL2013 nabeschouwing

Statistiek

Er staan 38 lezingen aangekondigd in het programma boek. Er was een panel met 8 presentaties en de postersessie opende met 28 1-minuut/presentaties. In mijn tutorial waren 5 presentaties en er werden in totaal 6 tutorials gehouden, en een Doctoral Consortium met 6 lezingen. In mijn workshop werden 12 presentaties gegeven en er waren 6 workshops. Dat komt dan grof geteld bij elkaar op 182 presentaties.In de officiele proceedings, die door Springer worden gepubliceed onder de titel ´ Research and Advanced Technology for Digital Libraries` staan 72 hoofdstukken. Er waren 300 deelnemers uit 40 landen. Zelf heb ik 45 sprekers gehoord, 6 blogpostjes geschreven in 16 Word-bladzijden met in totaal 4552 woorden, 102 hyperlinks, 19 afbeeldingen en er werden zo´n 40 EU-projecten besproken. Kortom een boordenvol congres.

Digital Libraries

De TPDL, opgericht als European Conference on Digital Libraries, o.m. door Ecrim(European Research Consortium for Informatics and Mathematics) is bedoeld om onderzoekers in computertoepassingen over hun nieuwste onderzoeken te laten vertellen. Hoewel er ook, gedurende de hele conferentie telkens weer het belang van bruggen bouwen tussen ICT en publiek aan bod kwam, lag de nadruk ook wel erg op de technologische ontwikkelingen.

De formele defintie van ‘digital library’uit het Digital Library Reference Model luidt:

"A potentially virtual organisation, that comprehensively collects, manages and preserves for the long depth of time rich digital content, and offers to its targeted user communities specialised functionality on that content, of defined quality and according to comprehensive codified policies."

Onderwerp

De titel van het congres was “Sharing meaningful information” en het centrale thema kan worden samengevat in 3 woorden:

samenwerking, linking, semantisch web.

De twee keynote-sprekers waren goed gekozen en vertegenwoordigden ook de essentie van de hele conferentie: Christine Borgman gaf alvast een inkijkje in haar nieuwe boek Big Data, Little Data, No Data,dat zal gaan over nieuwe vormen van wetenschappelijke comunicatie, openheid als norm voor het wetenschappelijk proces en hergebruik van data als uitgangspunt voor nieuw onderzoek.

En de tweede keynote-spreker Sören Auer sprak over linked data. Hij is de man van het “Wikipedia semantification project DBpedia or the social Semantic Web toolkit OntoWiki” en toonde verschillende semantische tools en bijv. ook om als transitie maatregel te beginnen met het semantisch annoteren van pdfs..

Hij sprak over de linked data life cycle, en over de noodzaak om de digitale bibliotheken opnieuw uit te vinden en te trransformeren naar 'knowledge hubs'.

In het vervolg van de conferentie kwamen deze begrippen steeds weer terug, soms met wat meer nadruk om text extractie, soms meer nadruk op kunstmatige intelligentie, soms op crowdsourcing, en soms ging het om de welbekende discussie van waardering en erkenning en het publiceren in high impact factor journals.

De tutorial die ik volgde gaf me een stevige introductie in data curatie. Data curatie, aldus tutorial-leider Andreas Rauber is niet genoeg, en ook een Data management plan volstaat niet. De uitdaging is om het proces, in zijn context vast te leggen

we need to move beyond the concept of data and capture ‘all’ elements of a research processDe demo's in de tutorial en de verhalen eromheen werden gegeven vanuit het project Wf4ever Workflow 4ever, dat draait om het preserveren van workflow in research objects. Ook semantisch geannoteerde papers kunnen tot research object worden omgewerkt en zo sloot ook dit verhaal naadloos aan op de rest vna de conferentie.

De workshop waarmee het geheel eindigde was een waterval aan resultaten en halfresultaten van onderzoeken in de richting van data curatie, data en publicatie verrijking en het semantisch annoteren. Het kwam weer terug op linked data, het linken van publicaties aan data en data aan de research workflow.

De presentaties van de workshop staan inmiddels op de site.

Na de conferentie heb je meestal het gevoel dat er een thuiswerkopdracht aan vast zit, in het Engels vaak 'take home message' genoemd. Voor mij is dat tweeledig:

- research workflow systemen Taverna / My Experiment nakijken op hun waarde en bruikbaarheid.

- winter weblecture in semantische web technologieen van Uni Bonn (Auer).

En uiteraard kijk ik met belangstelling uit naar het nieuwe boek van Christine Borgman.

3 okt 2013

LCPD workshop TPDL 2013

De eerste workshop :"Linking and Conceptualizing Publications and Datasets" gesponsord door OpenAire en Eurocris werd gehouden onder het motto: 'Paving the way towards Modern Scholarly Communication'.

De workshop van 1 dag, beslaat 5 sessies waarin 10 voordrachten worden gehouden. Het programma lijkt tamelijk volgepakt. Alle voordrachten geven een onderzoek weer op het gebied van het linken en conceptualiseren van publicaties en data.

De twee 'invited speakers'zijn Sarah Callaghan en Soren Auer. Auer hebben we daags ervoor al gehoord met zijn Linked Data en nu legde hij de nadruk op het semantisch annoteren. Dat kan ook met publicatie-PDFs. Alleen moet je daar wel een modus voor vinden zodat het annoteren voor de onderzoeker uiteindelijk lonend blijkt te zijn. Helemaal opheffen van de pdf ziet hij niet direct gebeuren er is een tijd van transitie nodig.

Sarah Callaghan vertelt over haar ervaringen met data als onderzoeker, in een geval het handmatig bij elkaar sprokkelen en ordenen van de gegevens en in het tweede geval het onmiddellijk archiveren van de data gelinkt aan het artikel. Om e.e.a. te verduidelijken gebruikt ze de datapyramide (plaatje uit presentatie Smit over ODE - Opportunities for Data Exchange).

Ze is voorstander van data publicaties in een data journal en van een correcte datacitatie. Zie ook het rapport van CODATA (Committee on Data for Science and Technology van de International Council for Science) "Out of Cite, out of mind". In dit rapport worden de eerste 10 principes van datacitatie geformuleerd:

1. Status of Data: Data citations should be accorded the same importance in the scholarly record as the citation ofBut it is crucial, she concludes, that data and publications resulting from it must be linked!

other objects.

2. Attribution: Citations should facilitate giving scholarly credit and legal attribution to all parties responsible for

those data.

3. Persistence: Citations should be as durable as the cited objects.

4. Access: Citations should facilitate access both to the data themselves and to such associated metadata and

documentation as are necessary for both humans and machines to make informed use of the referenced data.

5. Discovery: Citations should support the discovery of data and their documentation.

6. Provenance: Citations should facilitate the establishment of provenance of data.

7. Granularity: Citations should support the finest-grained description necessary to identify the data.

8. Verifiability: Citations should contain information sufficient to identify the data unambiguously.

9. Metadata Standards: Citations should employ widely accepted metadata standards.

10. Flexibility: Citation methods should be sufficiently flexible to accommodate the variant practices among

communities but should not differ so much that they compromise interoperability of data across communities.

Aan het eind van haar presentatie roept Sarah Callaghan op om mee te doen met een nieuwe - Cost?-actie om het publiceren van data en publicaties gecombineerd te stimuleren:PARD: Publish Academic Research Data.

Ze refereerde daarbij aan het blog van Graham Steele: 'Publishing research without data is simply advertising, not science'

Na de koffie was er een sessie over 'Datasets en Contextualization' waarbij het ging over NLP (Natural anguage Processing), en over het belang van metadata bij klimaatgegevens (CHARMe-project).

In de sessie over 'Interlinking of Publications and datasets" werd een aardig onderzoek van de KU Leuven gepresenteerd over antieke teksten, verzameld in een Filemaker database(Trimegistos) en om te zetten (kan 'fairly straightforward') naar RDF. De leider van de workshop Paolo Manghi hield zelf een introductie in de tool Data Searchery, een prototype om te zoeken in databestanden naar soortgelijke datasets. Nog een aardig linking onderzoek werd gepresenteerd door Nuno Lopes, die met Linking Logainm een LOD-demonstrator presenteert waarmee je op Ierse plaatsnamen kunt zoeken in bestanden van de Nationale Repository van Ierland.

Na de pauze in de sessie 'Datavisualizations and representation' presenteerde Martin Skulimoski een veelbelovend platform "Link Your Research' waar de verschillende entiteiten van een research paper gelinkt kunnen worden aan andere onder het motto"Publish articles, publish your data and link your concepts!".

Andras Micsik demonstrateert een andere linked open data-toepassing genaamd: LODmilla, die relaties tussen datasets linkt en als laatste volgt een verhaal over de OpenAire mining services.

In de laatste sessie gaat het over 'metadata and packaging' en komen aan bod 'Cerif voor datasets' en metadata voor grote datasets naar 'investigation research objects'. Wat me uiteindelijk weer terugvoert, en ook de discussie terugvoerde naar Research Objects (behandeld in de tutorial van zondag).

2 okt 2013

TPDL 2013 Semantisch Web

Dinsdagnamiddag kregen we nog een plenaire bijeenkomst rondom het semantisch web.

Semantic searching was al eerder ter sprake gekomen, en bij veel onderzoeken kwam het woord 'semantisch' op de een of andere manier naar boven drijven.

De officiële W3C website zegt erover:

The term “Semantic Web” refers to W3C’s vision of the Web of linked data. Semantic Web technologies enable people to create data stores on the Web, build vocabularies, and write rules for handling data. Linked data are empowered by technologies such as RDF, SPARQL, OWL, and SKOS.En vooral RDF, SPARQL en OWL kwamen uitbundig aan bod.

Hierarchical Structuring of Cultural Heritage Objects within Large Aggregations

Shenghui Wang van OCLC sprak rondom het probleem van duplcaten in Europeana, hoe die op te sporen en te categoriseren. Immers eenzelfde beschrijving kan meerdere kanten van een object belichten, de bedoeling is dan die bij elkaar horende of op elkaar gelijkende objecten aan elkaar te linken. Ze gebruiken daarvoor de techniek van iteratieve paralelle clustering met minhashes (min-wise independent permutations locality sensitive hashing scheme).

Methodology for Dynamic Extraction of Highly Relevant Information Describing Particular Object From Semantic Web Knowledge Base

Krzysztof Sielski noemde Clepsydra, een aggregator die de collecties van diverse bibliotheken samenbrengt in een knowledge base. Ze gebruiken daarvoor een RDF database en SPARQL queries gebaseerd op de FRBRoo Ontologie. Met een ontologie maak je een conceptueel schema van een bepaald domein, in hierarchie opgebouwd met aanduiding van onderlinge relaties (een soort thesaurus). In de gezamelijke digitale bibliotheek kun je al, niet helemaal volgens het nieuwste algoritme, maar toch al een aanzet de ontwikkelingen daaraan zien. Als voorbeeld zoeken op Hamlet, biedt dus verrijkte catalogus.

Personalizing Keyword Search on RDF Data

Giorgos Giannopoulos presenteert het zoeken op via ranking algoritmes op een RDF database.

Providing Meaningful Information in a Large Scale Digital Library - a Case Study

Patricia Herterich van CERN over de problemen bij het identificeren van auteursnamen. Met INSPIRE, het informatiesysteem van CERN dat een samengaan is van diverse digitale bibliotheken en systemen. Met het Europese ODIN project, proberen ze, op basis van de ORCID en DATACITE initiatieven verder te bouwen aan een automatische auteurs-identificatie.

Keynote:

What can Linked Data do for Digital Libraries?

Sören Auer spreekt over het LOD2-project, een groot EU-project over Linked Open Data, dat bedoeld is om meer open data aan elkaar te knopen en toegankelijk te maken.

How can we reinvent Libraries online: Digital Library is a Digital Knowledge Hub, exploring new ways of sharing knowledge, not just access to digital stuffDe digitale bibliotheek ondersteunt verschillende soortenproducten, technologieen en interactieve samenwerkingsvormen.

Lod2 heeft een aantal tools ontwikkeld, Ontowiki en Slidewiki, die gebruikt kunnen worden om de wetenschappelijke communicatie te bevorderen.

Lees ook: "Managing the life cycle of linked data with the Load2 stack."

Vervolgens raakte Auer aan een punt want meerdere keren al ter sprake kwam, nl de semantische annotatie:

..publish semantic papers as an intermediate step, not directly in rdf knowledge base but as enriched annotated paper

De conferentie eindigde voor mij met een sessie over Preservation.

Restoring Semantically Incomplete Document Collections Using Lexical Signatures

Luis Meneses vroeg zich af wat er gebeurt als je een document niet meer terug kunt vinden, als er in een reeks iets ontbreekt. Hoe weet je dat? en als je het al kunt reconstrueren hoe betrouwbaar is die reconstructie dan?

Resurrecting My Revolution: Using Social Link Neighborhood in Bringing Context to the Disappearing Web

Michael Nelson vertelt over een tweet-onderzoek onder tweets van 6 belangrijke sociale events (opstand in Egypte, oorlog in Irak etc.) en gaat op zoek naar eventuele ontbrekende link-locaties. Zijn die weer terug te halen? M.b.v. Topsylab konden van een onderwerp dat voldoende tweets heeft een dossier gemaakt worden waaruit ev. ontbrekende link-locaties kunnen worden aangevuld.

Who and What Links to the Internet Archive

In zijn tweede praatje laat Michael L. Nelson zien dat de bestaande web-archieven minder goed zijn als ze beloven.

Aan het eind van de conferentie werd er nog een foto gemaakt op de trappen van het Grand Hotel Excelsior.

30 sep 2013

TPDL 2013 Dinsdag

Digital Libraries and eInfrastructures - The Future?

Wim Jansen, Roberto Barbera, Michel Drescher, Antonella Fresa, Matthias Hemmje, Yannis Ioannidis, Norbert Meyer, Nick Poole, and Peter Stanchev

De panelvoorzitter, Wim Jansen is verbonden aan het EU-DG Connect (Digitale Agenda onder Neelie Kroes) en in deze sessie, meer nog dan in de andere sessies schoten een overdaad aan acroniemen van EU-projecten voorbij.

Hij verwacht dat in Horizon 2020 – de agenda staat nog niet vast – Call 3 en 4, die eind 2014 van start gaan interessant zullen zijn voor e-Infrastructures. Onder de vroegere FP en FP 7 programma´s en ook al daarvoor is er hard gewerkt aan Europese infrastructuur projecten. Er is een Research Infrastructures EU website en een EU Research Infrastructures Portal, waar je in een database kunt zoeken naar bepaalde infrastructurele werken

The term ‘research infrastructures’ refers to facilities, resources and related services used by the scientific community to conduct top-level research in their respective fields, ranging from social sciences to astronomy, genomics to nanotechnologies.ESFRI, the European Strategy Forum on Research Infrastructures, is a strategic instrument to develop the scientific integration of Europe and to strengthen its international outreach. ESFRI heeft zojuist een rapport uitgegeven met daarin een assessment van de projecten, waaronder bijv. DARIAH (geesteswetenschappen, assessment rapport p. 15) en Lifewatch (levenswetenschappen, assessment rapport p. 31).

Voor de geesteswetenschappen is er nu DCH-RP (Digital Cultural Heritage Roadmap for Preservation), die een e-Culture Science Gateway ontwikkelden, die inzicht geeft in culturele databestanden, die zijn opgeslagen in het European Grid Infrastructure.

Shaman gaat over cultureel erfgoed: Sustaining Heritage Access through Multivalent Archiving. Het Shaman project is afgerond en het eindrapport kan worden gedownload. Het Enumerate project verzamelt statistische gegevens over het cultureel erfgoed.

Een overkoepelende organisatie is Eudat,een EU organisatie die samenwerking stimuleer tussen data service providers en data gebruikers c.q. ontwerpers. Speerpunten voor Eudat zijn:

Safe data replication, Data staging, Simple store, Metadata, AAI (Authentication and Authorization Infrastructure).Ook hier zijn weer de communities van o.m. Lifewatch en CLARIN vertegenwoordigt.

En dan is er nog Chain-reds (Co-ordination & Harmonisation of e-Infrastructures for Research and Education Data Sharing) met als doel:

..in order to define a path towards a global e-Infrastructure ecosystem that will allow Virtual Research Communities (VRCs), research groups and even single researchers to access and efficiently use worldwide distributed resources (i.e., computing, storage, data, services, tools, applications).En het European Grid Infrastructures (EGI) project, dat virtuele organisaties van onderzoekers samenbrengt met software en service mensen.

Tot slot nog een woordje over OpenAire, de Open Access infrastructuur van de EU, waar iedereen zijn publicaties kan deponeren en ondersteuning kan vinden voor het oa publiceren.

De toekomst gaat over samenwerken, niet meer ad hoc eigen systemen bouwen , maar een generic core waaromheen ieeder zijn community kan bouwen. De toekomst gaat ook over filtering en eventuele filtering tools, 'the theory of forgetting', een stelling is dat er een goed economisch model ontbreekt. Veel is nog in ontwikkeling.

Tijdens de pauze klaagde een Amerikaanse dame dat het wel erg veel en erg verwarrend is allemaal (en dat is het ook:).

Na het EU vuurwerk was er tijd voor een sessie over ‘Mining and Extracting’.

Stefan Klamp begon met An Unsupervised Machine Learning Approach to Body Text and Table of Contents Extraction from Digital Scientific Articles”

Voor deze paper is hij beloond met een ‘Best Paper Award’.

Hij beschrijft hoe hij een programma ontwikkelt dat pdfs leest en de strcutuur daarvan probeert te herkennen. Dan kan indien de kopjes herkent zijn een inhoudsopgave worden gegenereerd.

Ook bij de UvA (is.m. Kitlv) wordt soortgelijk onderzoek gedaan.

Entity Network Extraction based on Association Finding and Relation Extraction

Ridho Reinanda, presenteerde gisteren, tijdens de postersessie, in een demo een ngramviewer die een voorbeeld laat zoeken naar iets soortgelijks ‘associate finding’.

given an input entity and a document collection, extract related entities from the collection and present them as a networkAls voorbeeld gebruikten ze de toespraken van de Indonesische presidenten.

Nuon Freire boog zich over de vraag hoe hij correct de namen vanauteurs uit de tekst kan extraheren., voor gebruik in nationale bibliografieën.

Word Occurrence Based Extraction of Work Contributors from Statements of Responsibility. In de toekomst zal er meer gekeken worden naar integratie met FRBR (Functional Requirements for Bibliographic Records), VIAF (Virtual International Authority File) en ISNI (International Standard Name Identifier).

Dit werk werd uitgevoerd in het kader van de EU projecten The European National Library en het Arrow Plus Network.

Dinsdagmiddag was het de beurt aan de sessie over “Interfaces for Digital libraries”

Exploring Large Digital Library Collections using a Map-basedVisualisation

Mark Hall sprak over ‘spatialisation’, een poging om de toegang tot grote collecties te visualiseren. Daartoe is eerst een thesaurus gebouwd met een hiërarchische structuur, daarna zijn er per document ‘bag-of-words’ gemaakt en geschoond. Op basis van die bag-of-words zijn de TD-IDF (term frequency–inverse document frequency) vectoren berekend, waarmee een kaart getekend kan worden. In het PATHs project wordt de visualisatie gebruikt.

AugDesk. Fusing Reality with the Virtual in Document Triage. Part1: Gesture Interactions

George Buchanan

Een onderzoek in het domein vna de augmented reality: sorteren van documenten door gebaren De gebaren worden geregistreerd met een Microsoft Kinect Sensor.

The Role of Search Interface Features During Information Seeking

Pertti Vakkari

In dit onderzoek werd gekeken naar het resultaat van een verrijkte zoekinterface bij verschillende soorten van zoekacties, known item en explorerend zoeken. Er werd gebruikt gemaakt van start pagina;s zoekboxen en gerelateerd zoeken. Kernprobleem is de vraag wat aan search features ligt en wat aan de toepassing ervan in de interface.

Users Requirements in Audiovisual Search: a Quantitative Approach

Roeland Ordelman sprak (namens Beeld en Geluid) over het Axes project, access to audiovisueel archive

Onderzocht werden de verschillen en overeenkomsten tussen drie soorten gebruikers:professioneel, educatief en privé-personen. Wat zijn de specifieke gebruikerseisen en prioriteringswensen van de groepen gebruikers.

Ordelman refereerde ook nog aan het Project Infiniti dat beoogd open standaarden te ontwikkelen voor tools die semantisch zoeken mogelijk maken.

's-Avonds kregen we een diner aangeboden in de historische stad Mdina, waar we werden opgewacht door 16e eeuwse wachters met trommels en fakkels, zeer sfeervol.

29 sep 2013

TPDL 2013 Maandag

De track op maandagochtend die ik had uitgekozen “Conceptual Models and Formal Issues”begon al goed doordat de eerste spreker niet kwam opdagen. De laatste spreker zou gaan praten over e-books in Zweedse openbare bibliotheken, dus dat trok me ook niet zo. Resteerde 2 lezingen.

De eerste over citizens science en de tweede over de definiering van digital libraries.

Hussein Suleman begon met een aardige presentatie van zichzelf door de stellen dat het land waaruit hij kwam ‘on top of the world’ ligt, en dat doet Zuid-Afrika ook als je het omgekeerd van het normale beeld voor je ziet. Een leuke aanzet tot een andere kijk op het onderwerp.

Quality Assessment in Crowdsourced Indigenous Language Transcription

Men had geprobeerd om een collectie aantekeningen van de oorspronkelijke bewoners van Zuid Afrika, die een onbekende taal spraken via kunstmatige intelligentie en allerlei linguistische computertechnieke n te ontcijferen. Dat was niet gelukt, althans niet met voldoende accuraatheid. Daarom besloten ze te onderzoeken of het zinvol was om vrijwilligers in te zetten, die m.b.v. een online tool de teksten zouden transcriberen.

Het bleek dat de vrijwilligers, vooral als verschillende versies over elkaar werden gelegd een behoorlijke graad van accuraatheid bereikten. Bleef alleen nog de vraag hoe je aan voldoende vrijwilligers komt om de klus te klaren. In een eerder artikel schreef Suleman daarover, hij zette daarvoor games in, want zei hij : ‘de vrijwilligers willen erkenning, zien dat ze het goed doen en liefst nog beter dan de anderen’

De tweede spreker Armand Brahaj probeerde het begrip ‘digitale bibliotheek’ nader te definieren.

Defining digital library

Hij wilde het begrip digitale bibliotheek benaderen zowel vanuit een linguistisch als classificatorisch standpunt. Opmerkelijk genoeg ging hij daarbij uit van de defintie van een digitale biblotheek als een online collectie, en niet bijvoorbeeld van het concept bibliotheek.

Vereist dus toch nog wel enige nadere conceptuele bewerking.

Uiteindelijk kwam hij met een aantal trefwoorden die allen een relatie hebben tot ‘digitale bibliotheek’:

De TPDL, opgericht als European Conference on Digital Libraries, o.m. door Ecrim is bedoeld om onderzoekers in computertoepassingen over hun nieuwste onderzoeken te laten vertellen. Hoewel er ook, gedurende de hele conferentie telkens weer het belang van bruggen bouwen tussen ICT en publiek aan bod kwam , lag de nadruk ook wel erg op de technologische ontwikkelingen.

De formele defintie van ‘digital library’uit het Digital Library Reference Model luidt:

"A potentially virtual organisation, that comprehensively collects, manages and preserves for the long depth of time rich digital content, and offers to its targeted user communities specialised functionality on that content, of defined quality and according to comprehensive codified policies."

[zie ook Wikipedia over ‘digital libgraries’. NB Delos en dl.org zijn afgesloten EU-projecten over Digtal Libraries]

Er werd een uitgebreide en goed verzorgde lunch geserveerd (konijn, een Maltezer specialiteit, hoewel we zondagmiddag in een trip door de ‘countryside’ weinig open platteland gezien hadden. Malta blijkt een behoorlijke steenwoenstijn en de kleine akkertjes werden werden zwaar doortrokken door stangen en buizen voor de irrigatie).

Na de lunch volgde een tamelijke lange sessie over “Digital Curation”.

Mark Hedges beet het spits af met :”Digital Libraries for Experimental Data: Capturing Process Through Sheer Curation”.

Net als tijdens het tutorial was hier sprake van een poging om het proces van onderzoek, en niet zozeer de onderzoeksdata zelf bast te leggen.

Althans, de data waren er wel, er werden wel allemaal trouw bestanden bewaard, maar de relaties van die bestanden tot elkaar en de verschillende vormen en volgordes kon daar niet uit worden opgemaakt dus was de vraag :”where is the story of the experiment”.

Met de methode van het Open provenance model probeerden Hedges cs het hele proces te ‘capturen’ met minimale last voor de onderzoeker. ‘Sheer curation’is het kernbegrip en duidt op de minimale belasting voor de onderzoeker terwijl wel zijn bestandsmanipulaties door een speciale desktop tool worden vastgelegd en het proces van de verschillende versies en onderlinge afhankelijkheden van bestanden in repositories werd bewaard.

Sheer curation is an approach to digital curation where curation activities are quietly integrated into the normal work flow of those creating and managing data and other digital assets.

De volgende twee sprekers haken aan bij Europeana. Europeana werd trouwens toch heekl vaak genoemd op de conferentie en speelt duidelijk een belangrijke rol .

Europeana is a catalyst for change in the world of cultural heritage.De Europeana Foundation & Network onderhouden een belangrijke portal, maar voeren ook vernieuwende projecten uit.

Er gebeurt echt wel veel binnen de Europeana community, ik heb me dan ook maar aangemeld voor de nieuwsbrief en wilde ontwikkelingen daar wat beter bijhouden.

Giannis Skevakis on “Metadata Management and Interoperability Support for Natural History Museums”. In het Natural Europe Project proberen de partners de toegankelijkheid tot het cultureel erfgoed in de musea voor natuurlijke historie beter toegankelijk te maken.

Het door de Universiteit van Kreta ontwikkelde Multimedia Authoring Tool is een web-based programma dat gebruikt kan worden om digitale object-collecties te beschrijven en te verrijken. Ook kan de MMAT gebruikt worden om gegevens mee uit te wisselen naar andere biodiversiteits-collectie-netwerken zoals BioCase, GBIF en Europeana.

De MMAT is gebouwd met Google Toolkit technologie en kan gebruikt worden in de gehele metadata life-cucle van ergoed objecten (CHO’s = cultural heritage objects).

Dimitri Gavrilis heett het in zijn praatje “A Curation-Oriented Thematic Aggregator”over Europese archeologische monumenten, het Carare project: Connecting ARchaeology and ARchitecture in Europeana. Via Europeana kun je nu de momenumenten zoeken . Op een kaart zijn een groot aantal monumenten aangegeven.

Aanvankelijk werd gebruik gemaakt van het Premis metadata model (preservation metadata), maar uiteindelijk werd de data overgebracht naar het Europeana Metadata Model (EDM).

De laatste presentatie was niet zozeer over curatie als wel over bibliometrie. De centrale vraag was of sociale media indicatoren een relatie hebben naar de uiteindelijke citatiescore :” Can Social Reference Management Systems?” Hamed Alhoori begint met het statement dat het door de informatie overload komt, dat we ranking hebben. Er is veel aan te merken op de huidige methoden van wetenschappelijke impact metingen, bijv. dat opvragen nog niet hetzelfde is als lezen. Sociale reference sites zoals CiteuLike en Mendeley, daar worden de genoemde artikelen ook echt gelezen. Wat als je die sites vergelijkt met de traditionele zoals Journal Impact factor, EigenFactor, Google H5 etc. De conclusie is dat er wel een correlatie is tussen het vorokomen in de social reference sites and de andere impactmetingen. Alhoori baseert zich op een artikel uit 2009, waarin Bollen e.a. 39 rankings om wetenschappelijke artiekelen te meten naast elkaar legden.

Na de presetnaties was het tijd om naar de tentoonstellingsruimte te gaan. Daar kregen alle auteurs van een poster de kans om in een minuut uit te leggen wat er op hun poster staat. - Op de foto staan de kandidaten in de rij om hun verhaal te vertellen. Na de poster sessie was er een receptie op het ravelijn terras.

23 sep 2013

TPDL 2013 Keynote

De COST-vertegenwoordigster memoreerde dat de Johannieter Orde (sinds 1564 Valetta), de eerste Europese samenwerking was.

[Heb een fraaie catalogus gevonden van een tentoonstelling uit 2009 van de archieven van de Johannieters).

*

De openings keynote wordt uitgesproken door Christine Borgman. Van haar had ik al het boek gelezen “Scholarship in the digital age.

Christine Borgman.MIT Press, 2007. Goed gedocumenteerd boek met een beschrijving van de nieuwste ontwikkelingen op het gebied van wetenschappelijk onderzoek. Heel breed en daardoor worden veel onderwerpen slechts aangestipt. Ook over het belang van incentives voor het opslaan van data bijvoorbeeld. Geeft toch een aardig overzicht van de gevolgen van internet voor onderzoek.Ook in deze keynote blijkt ze goed gedocumenteerd en geeft een heel mooi overzicht over een van de grootste issues in de wetenschap: Research Data Management. Digital scholarship, aldus Borgman "encompasses the tools, its about services and infrastructure that supports research too". Daarbij noemt ze ook nog het het recente OA rapport waaruit blijkt dat al meer dan de helft van de publicaties openbaar toegankelijk zijn.

Binnenkort komt er een nieuw boek van haar uit: “Big data, small data, no data: digital libraries past, present and future“ Daarin beschrijft ze vier duidelijke trends:

1. Open scholarship is norm (open data, open collaborations, open publication, open dissemination, open ontologies, open access attitudes)

2. Formele en informele publicaties lopen door elkaar heen, dus ook credits (altmetrics) [al in 1964 beschreven Garvey & Griffith in Science het verschil – ook in waardering – tussen formele en informele publicaties]

3. Data is lokaal bepaald (big data kan ‘big’ zijn in omvang, varieteit en snelheid (velocity) verschil tussen disciplines ‘índustrial tools vs artisanal tools’, long tail

4. Open data veroorzaakt een paradigma verschuiving (doel van onderzoek is niet langer de publicatie maar het hergebruik van de data)

Data sharing is not a technical issue, but a cultural

Haar presentatie is beschikbaar via haar website.

22 sep 2013

Tutorial TPDL 2013

Het 17e International Congress on Theory and Practice of Digital Libraries begon vanochtend in het Grand Hotel Excelsior in Floriane(Valetta) op Malta met de tutorials.

Ik had me ingeschreven voor de tutorial: “From Preserving Data to Preserving Research: Curation of Process and Context” die georganiseerd werd door deelnemers aan het EU-project Wf4ever (Workflow for ever), waarbij het vooral gaat om de digitale curatie van het onderzoeksproces.

In zijn introductie ging Andreas Rauber in op het Microsoft boek The fourth paradigm, dat - gebaseerd op de concepten van Gray de ontwikkeling van de wetenschap ziet in 4 fasen: empirisch, theoretisch, computationeel en (nu) data-driven.

En wat heeft data-driven science meer nodig dan curatie?!

Een DMP (data mangement plan) is niet genoeg, aldus Rauber en hij haalt een casus aan waarbij door verandering in software eerder uitgevoerd onderzoek niet meer repliceerbaar was.

De uitdaging is om het proces, in zijn context vast te leggen

we need to move beyond the concept of data and capture ‘all’ elements of a research process

Rudof Mayer deed daarna het onderzoek uit de doeken. Hij heeft een model gemaakt van een methode die muziek automatisch kan caegoriseren. Daarbij maakte hij gebruik van externe bronnen voor de data en probeerde de kenmerken te exteaheren en via een machine-leerproces de software te finetunen.

Om dit proces te beschrijven maakte hij gebruik van een bestaand metadata model genaamd ArchiMate.

ArchiMate kan verschillende layers beschrijven in de processen voor informatieontsluiting, gedrag en structuur. Uiteindelijk leidde dat tot ontologieen.

Rudolf Mayer legt het proces van process- capturing uit, ook beschreven in Timbus- Project.

Het basismodel wat daaruit ontstond heeft hij uitgebreid met verdere ontologieen, met gebruikmaking van verschillende tools, zoals the software ontology, mapping metadata met Premis, CUDF voor software dependencies, en handmatig voor sensors.

Ze hebben verschillende tools ontwikkeld om een aantal van die gegevens automatisch te extraheren, maar die moeten wel worden aangevuld met handmatige aanvullingen.

Na Mayer was het de beurt aan Daniel Garijo en Raul Palma om het idee van Research Objects uit te leggen en te demonstreren. Ze lieten zie hoe het door Mayer in ontologieen beschreven proces kan worden omgezet naar Research Objects. Een Research Object is een bundel van alle bronnen die nodig zijn voor een -experimenteel - onderzoeksproces. The resources aggregated by a Research Object can be: data used or results produced in an experiment study; (computational) methods employed to produce and analyse that data; or people involved in the investigation

* Tijdens de koffie verduidelijkte Daniel dat nog eens door te zeggen dat ook bijvoorbeeld een pdf van een publicatie met al zijn onderdelen een Research Object kan zijn.*

Annotatie is belangrijk voor een Research Object.

Waarom linked data niet genoeg is voor onderzoekers is de titel van een artikel van Bechhofer e.a. in Recent Advances in e-Science, en het antwoord is Research Objects.

Tijdens de demo over het maken van een Research Objects liet Raul Palma zien hoe de met ontologien beschreven en bewaarde workflow van Mayer omgezet kon worden in een Research Object. Dat kan met gebruikmaking van MyExperiment van Taverne. Er is ook een video van.

Nu is e.e.a. nog in projectstatus, maar dat gaat als product verder gepresenteerd worden.

De tutorial eindigde met een presentatie van Stefan Proell over datacitatie.

Behalve over doi en datacite, ging het ook over andere 'name assigning authorithy numbers' bijvoorbeeld ARK,archival resource key.

Hij gaf ook een demonstratie hoe je zelf bijv een doi of een ark kunt toewijzen.

Al met al een boeiende tutorial, met genoeg aanknopingspunten om verder te lezen.

[de link met verwijzing naar de presentaties zal op de tutorial webpagina van tpdl 2013 komen]